Documentation utilisateur

- Qu'est-ce que redirection.io ?

- Guide de démarrage

- Que sont les organisations et les projets ?

- Inviter de nouveaux collaborateurs

- Compte utilisateur et préférences

- Utilisation des logs de trafic

- Créer une règle

- Référence des triggers et des marqueurs

- Référence des actions

- Comment importer ou exporter des règles de redirection en masse ?

- Gestion des instances

- Notifications du projet

- Segmentation des projets

- Combien ça coûte ?

- Puis-je utiliser redirection.io gratuitement ?

- À propos de nous

Documentation développeur

- TL;DR; Fast track

- Installation de l'agent

- Mise à jour de l'agent

- Référence de configuration de l'agent

- Intégrations disponibles

- L'agent en tant que reverse proxy

- Module nginx

- Module Apache

- Intégration platform.sh

- Cloudflare Workers

- Intégration Fastly Compute@Edge

- Middleware Vercel

- Utiliser redirection.io avec Docker

- Est-ce rapide ?

- API publique

Crawler

Instances managées

Base de connaissances

Versions legacy

Les instructions ci-dessous ont été personnalisées pour votre projet "".

Personnalisez ces instructions pour le projet

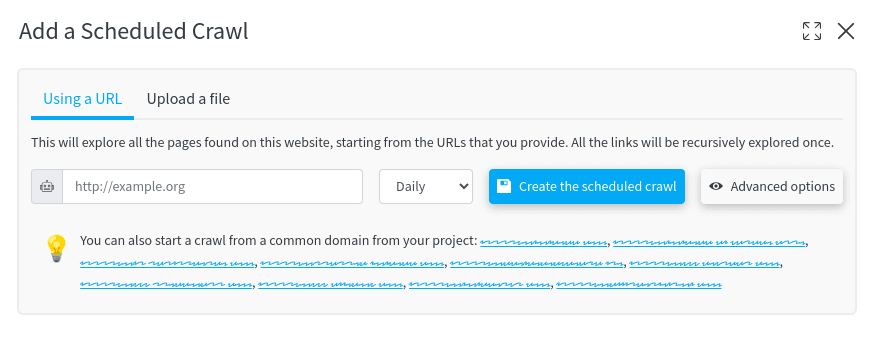

Planifier un crawl

Planifier un crawl permet de l'exécuter régulièrement. Les résultats du crawl seront disponibles sous l'onglet "Crawls", comme s'il avait été déclenché manuellement.

Exécuter des crawls régulièrement vous aide à suivre l'évolution de votre site web et à être informé des régressions, des nouveaux problèmes, etc.

Tous les paramètres du crawl peuvent être configurés comme pour un crawl manuel. Mais vous pouvez également choisir la fréquence du crawl, qui peut être définie sur :

- quotidiennement

- hebdomadairement

- ou mensuellement

Une fois qu'un crawl est terminé, vous pouvez analyser les résultats.

Vous pouvez être informé lorsqu'un crawl est terminé en mettant en place un canal de notification. Dans le cas des crawls hebdomadaires ou mensuels, cela peut être utile pour être informé des résultats directement dans votre boîte mail et garder un œil sur l'évolution de votre site web.