Les instructions ci-dessous ont été personnalisées pour votre projet "".

Personnalisez ces instructions pour le projet

Démarrer un crawl

Évidemment, la première étape pour utiliser le crawler de redirection.io est de lancer un crawl. Dans cette page, nous expliquerons comment lancer un crawl, et quelles sont les différentes options que vous pouvez configurer.

Lancer un crawl à partir d'une URL

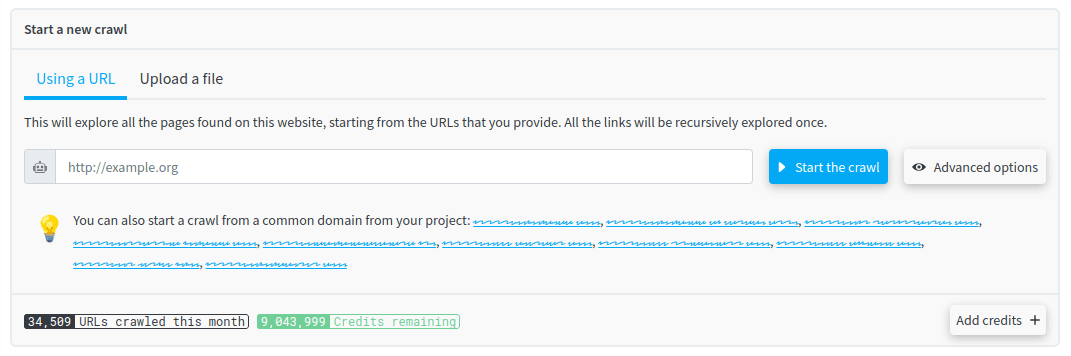

Depuis la page principale du crawler, vous pouvez lancer un nouveau crawl :

Vous devez remplir le champ avec une URL, et cliquer sur le bouton Lancer le crawl. Ensuite, le crawler de redirection.io commencera à télécharger cette page, et il suivra tous les liens contenus dans cette page, et ainsi de suite, de manière récursive.

Si vous avez déjà lancé un crawl, ou si redirection.io est déjà installé sur votre site web et a collecté des données, vous pouvez choisir l'une des URL proposées pour démarrer le crawl.

Selon le nombre de pages du site web et ses capacités de performance, le crawl peut prendre de quelques secondes à quelques heures. Mais vous pouvez fermer votre navigateur, le crawl continuera à s'exécuter en arrière-plan. Vous pouvez revenir plus tard pour voir les résultats, ou vous pouvez être notifié lorsque le crawl est terminé.

Paramètres avancés

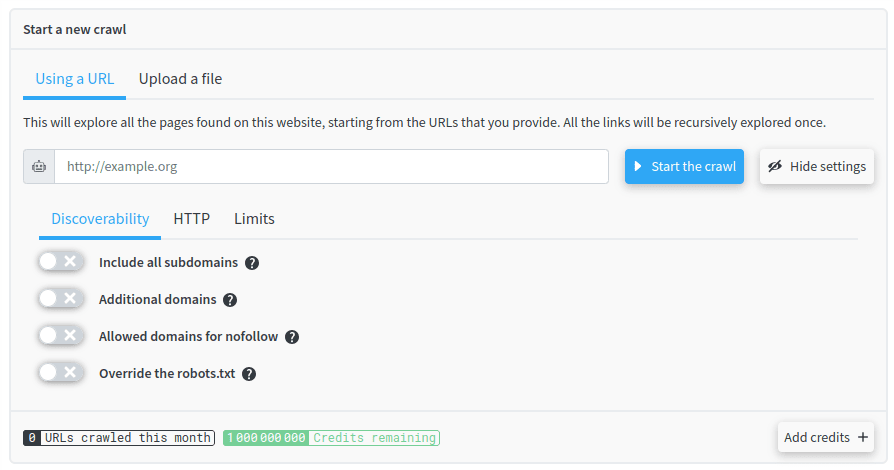

Vous pouvez également configurer la manière dont redirection.io explore votre site web en cliquant sur le bouton Paramètres avancés.

Sous l'onglet Découvrabilité, vous pouvez configurer la manière dont le crawler explorera votre site web :

- Inclure tous les sous-domaines : Si cette option est activée, le crawler explore également tous les liens des sous-domaines découverts. À utiliser avec prudence, cela peut générer beaucoup de trafic. Par exemple, si le crawler commence sur

example.comet trouve des liens absolus qui ciblentsub.example.com, il crawle également ces liens (et tous les liens qu'ils contiennent eux-mêmes). - Domaines additionnels : Écrivez ici d'autres domaines à crawler. Si une URL est découverte sur l'un de ces domaines, elle sera crawlée et explorée.

- Domaines autorisés pour nofollow : Écrivez ici d'autres domaines à autoriser. Lorsque redirection.io découvre un lien vers un domaine externe, il lèvera une erreur si l'attribut

rel=nofollowest manquant, sauf si le domaine cible figure dans cette liste. - Outrepasser le robots.txt. Par défaut, le crawler de redirection.io respecte les directives

robots.txtdes domaines crawlés. Cependant, vous pouvez remplacer le fichierrobots.txtpar défaut par un fichier personnalisé, ce qui est utile si vous avez besoin de crawler plus d'URL que ce que le fichierrobots.txtpar défaut autorise.

Sous l'onglet HTTP, vous pouvez configurer la manière dont le crawler interagit avec votre site web :

- Limitation automatique du débit : Notre moteur de crawler adapte et optimise automatiquement le débit de crawl pour correspondre aux capacités du site web, sans générer de ralentissements ou de problèmes sur votre site web. Cependant, vous pouvez contourner cette fonctionnalité et forcer une limite de débit spécifique et définir le nombre d'URL que le crawler téléchargera simultanément.

- Désactiver la vérification SSL : Si cette option est activée, le crawler autorise les connexions serveur non sécurisées lors de l'utilisation de SSL. Si elle est mal utilisée, cette option peut entraîner des problèmes de sécurité car elle permet de crawler des pages qui ont un certificat SSL invalide ou auto-signé. Cela peut cependant être utile si votre site web n'est pas encore disponible en production.

- Authentification HTTP : Elle permet de définir l'en-tête

Authorization: basic <value>. Ce paramètre est utile pour crawler des sites web de staging, par exemple, qui sont protégés par une authentification HTTP de base. Les mots de passe sont stockés chiffrés sur l'infrastructure de redirection.io. - User-agent personnalisé : Vous pouvez définir un user-agent personnalisé pour le crawler. Cela peut être utile si vous souhaitez simuler un navigateur spécifique, ou si vous souhaitez identifier le crawler dans vos logs. La valeur par défaut est

Mozilla/5.0 (compatible; redirection-io/1.0; +https://redirection.io/). - Remplacements d'hôtes : Avec cette option, vous pouvez remplacer la résolution DNS (l'adresse IP associée à un nom d'hôte) des domaines qui sont crawlés. Ceci est utile si vous souhaitez crawler un site web qui n'est pas disponible sur l'internet public, par exemple.

Sous l'onglet Limites, vous pouvez définir quand un crawl doit se terminer :

- URL crawlées illimitées : Si cette option est activée, le crawler continue à crawler jusqu'à ce qu'il ait trouvé toutes les URL sur le site web, quel que soit le nombre d'URL. Si elle est désactivée, le crawler s'arrête lorsqu'il a trouvé le nombre maximal d'URL.

- Profondeur de crawl illimitée : Si cette option est activée, le crawler continue à crawler jusqu'à ce qu'il ait trouvé toutes les URL sur le site web, quelle que soit la profondeur du site web. Si elle est désactivée, le crawler ne suit pas les liens qui sont plus profonds que la profondeur maximale.

- Durée de crawl illimitée : Si cette option est activée, le crawler continue à crawler jusqu'à ce qu'il ait trouvé toutes les URL sur le site web, quel que soit le temps que cela prend.

Lorsque vous avez configuré le comportement du crawler, cliquez sur le bouton Lancer le crawl pour que le crawler démarre.

Ce qui se passe pendant l'exécution du crawl

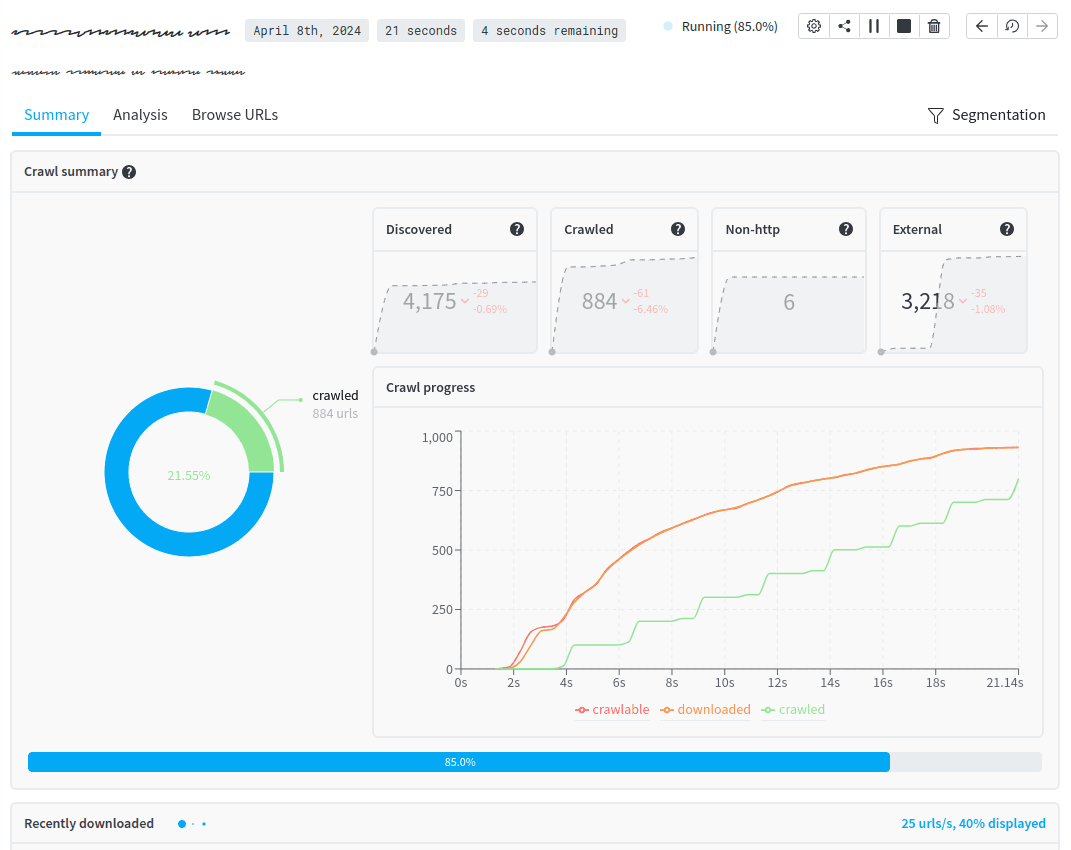

Une fois que vous avez lancé un crawl, vous pouvez voir la progression du crawl :

Dans le panneau Résumé du crawl, il y a 3 sections principales :

- en haut à droite

- URL découvertes : le nombre d'URL uniques qui ont été identifiées par le crawler. Ce nombre inclut toutes les URL (celles qui ont été crawlées, celles qui n'ont pas encore été crawlées, les URL non-HTTP, les liens externes, etc.)

- URL crawlées : le nombre d'URL qui ont été crawlées (c'est-à-dire qui ont été téléchargées et analysées)

- URL non-HTTP : le nombre d'URL qui n'utilisent pas le protocole HTTP(s) (par exemple, les liens

mailto:,ftp://outel:) - URL externes : le nombre d'URL qui ne sont pas sur le même domaine que l'URL de départ

- en bas à droite : un graphique montrant le nombre d'URL au fil du temps :

- URL crawlables : URL qui peuvent être crawlées

- URL téléchargées : URL qui ont déjà été téléchargées par le crawler

- URL crawlées : URL qui ont été crawlées (téléchargées et analysées) ;

- sur la partie gauche, le ratio entre le nombre d'URL crawlées et le nombre d'URL externes ;

Dans le panneau Récemment téléchargées, vous pouvez voir en temps réel la liste des URL en cours de téléchargement.

Une fois un crawl terminé, vous pouvez analyser les résultats.

En fait, vous n'avez pas besoin d'attendre la fin du crawl pour commencer à analyser les résultats. Dès le début du crawl, vous pouvez déjà accéder aux résultats partiels et commencer à les analyser, sous les onglets Analyse et Parcourir les URL de l'interface du crawler.

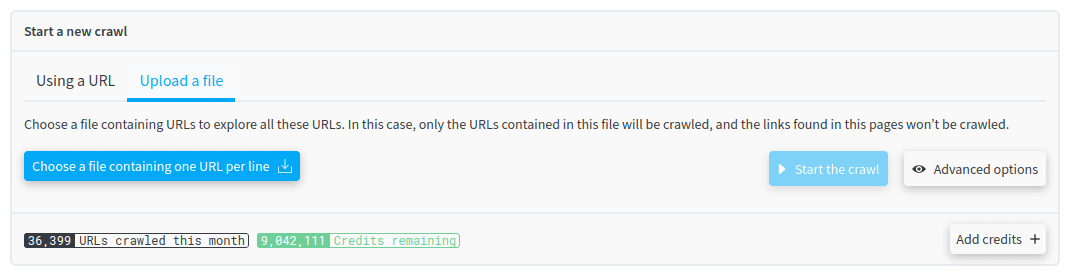

Lancer un crawl à partir d'une liste d'URL

Jusqu'à présent, nous avons vu comment lancer un crawl à partir d'une URL donnée. Mais que faire si vous souhaitez crawler une liste d'URL, par exemple pour vérifier si elles sont toujours valides ?

Le crawler de redirection.io vous permet de faire cela ! Si vous souhaitez surveiller une liste spécifique d'URL, vous pouvez télécharger un fichier texte contenant toutes les URL que vous devez crawler.

Le fichier doit contenir une URL absolue par ligne :

Comme toujours, vous pouvez configurer les paramètres du crawl en cliquant sur le bouton Paramètres avancés.

Planification des crawls

Planifier un crawl permet de l'exécuter régulièrement. Les résultats du crawl seront disponibles sous l'onglet "Crawls", comme s'il avait été déclenché manuellement.

La planification de crawls sur une base hebdomadaire ou mensuelle est un bon moyen de surveiller l'évolution de votre site web : vous pouvez voir si le nombre d'erreurs 404 diminue, si le nombre de pages augmente, etc.